Introducidas en la colección de cuentos I, Robot de 1950, las leyes de la robótica formuladas por el escritor Isaac Asimov (1920-1992) son un conjunto de pautas para regular el comportamiento de los androides y garantizar la seguridad del ser humano en sus interacciones con máquinas inteligentes. Preside la totalidad de los relatos contenidos en el volumen, casi siempre en un futuro en el que las figuras sintéticas serían una realidad común. La primera y fundamental regla establece que “un robot no puede dañar a un ser humano o, por inacción, permitir que un humano sufra daño”, y así se convierte en la piedra angular de un mundo feliz. En la adaptación cinematográfica de la antología de 2004, el detective Del Spooner sospecha que una de estas creaciones, Sonny, es el posible asesino de un célebre científico.

Si hablamos de este año 2025, apenas comenzado, la rápida evolución de la inteligencia artificial (IA) suscita fantasías similares en muchas personas y no es extraño escuchar aquello de que “cuál será el límite de la IA” si lograra independizarse de los designios humanos.

Una asociación entre investigadores de la Universidad de Stanford (Estados Unidos) y Google DeepMind permitió crear un modelo capaz de clonar la personalidad de una persona. Ni siquiera fue necesario desarrollar una tecnología revolucionaria, nunca antes vista. A través de las capacidades del modelo de lenguaje detrás de ChatGPT de OpenAI, el chatbot más popular del momento, los expertos replicaron el carácter, por así decirlo, de más de mil personas, basándose únicamente en entrevistas de dos horas. Fue sencillo: después de formular a los entrevistados una serie de preguntas sobre la infancia, la memoria y la carrera, entre otros tópicos, la computadora predijo el comportamiento de las personas implicadas en el trabajo.

“La promesa de la simulación del comportamiento humano (agentes computacionales de propósito general que replican el comportamiento humano en todos los dominios) podría permitir amplias aplicaciones en la formulación de políticas y en las ciencias sociales”, afirman los científicos en su paper, que fue publicado en arXiv, un repositorio de investigación científica en acceso abierto, pero no sometido a la revisión por otros pares, es decir, por otros expertos en el área.

Y describen su trabajo y sus hallazgos: “Presentamos una nueva arquitectura de agentes que simula las actitudes y los comportamientos de 1.052 individuos reales, aplicando grandes modelos de lenguaje a entrevistas cualitativas sobre sus vidas y midiendo luego cuán bien estos agentes replican las actitudes y los comportamientos de los individuos que representan. Los agentes generativos replican las respuestas de los participantes en la Encuesta Social General con un 85 % de precisión con la que los participantes replican sus propias respuestas dos semanas más tarde, y tienen un desempeño comparable en la predicción de rasgos de personalidad y resultados en réplicas experimentales. Nuestra arquitectura reduce los sesgos de precisión en los grupos raciales e ideológicos en comparación con los agentes a los que se les dan descripciones demográficas. La promesa de la simulación del comportamiento humano (agentes computacionales de propósito general que replican el comportamiento humano en todos los dominios) podría permitir amplias aplicaciones en la formulación de políticas y en las ciencias sociales”.

Las consignas

Al frente del equipo científico, Joon Sung Park realizó el sondeo como parte de su doctorado en informática de Stanford. Las personas reclutadas recibieron cien dólares por participar del estudio y representaron a diferentes edades, géneros, grupos raciales, regiones geográficas, niveles educativos e ideologías políticas. A partir de entrevistas con ellos, el equipo creó réplicas de agentes de esos individuos.

Para verificar qué tan bien los agentes imitaban a sus homólogos humanos, los participantes realizaron una serie de pruebas de personalidad, encuestas sociales y juegos de lógica, dos veces cada uno, con dos semanas de diferencia; luego los agentes completaron los mismos ejercicios. Los resultados de esas comparaciones arrojaron aquel 85 por ciento de similitud.

En el artículo, las réplicas se denominan agentes de simulación, y el objetivo al crearlas es facilitar a los investigadores en ciencias sociales y otros campos la realización de estudios que serían costosos, poco prácticos o poco éticos si se hicieran con sujetos humanos reales.

Estos agentes de simulación son ligeramente diferentes de los que dominan el trabajo de las principales empresas de IA en la actualidad, a los que se denominan “agentes de herramientas”. Entrenados a partir de correos electrónicos, mensajes de texto y otros archivos personales, que ayudan a crear una suerte de repositorio que se retroalimenta, estos agentes son modelos desarrollados para hacer tareas específicas en reemplazo de una persona, no para hablar con una persona. Pueden, por caso, ingresar datos, recuperar información que haya almacenado en algún lugar o, algún día, reservar viajes y programar citas.

La nueva tecnología, sin embargo, va más allá. Los agentes de simulación tienen como meta imitar los comportamientos y personalidades humanas, lo que permite a los investigadores estudiar la dinámica del mundo real en entornos controlados. La idea subyacente es que si es factible crear modelos de IA que se comporten como personas reales, los mismos pueden ser empleados para probar desde, por ejemplo, qué tan efectivas son las intervenciones en las redes sociales para lidiar con la desinformación hasta qué comportamientos causan embotellamientos en el tránsito. Al simular comportamientos humanos, proporcionan una alternativa escalable y ética a la participación de participantes reales en estudios sensibles o de gran escala.

Por ahora, la herramienta sólo ha sido probada con un número limitado de evaluaciones. Por lo tanto, no es posible saber si sería igual de eficiente al momento de replicar respuestas a situaciones más complejas, o que fueran más allá del alcance de las preguntas formuladas durante la entrevista. En cualquier caso, el desarrollo permite identificar los peligros potenciales.

La letra chica

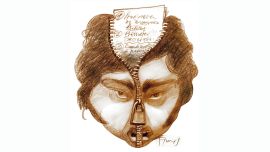

Hoy en día, las herramientas más difundidas ya permiten la creación de deepfakes, audios y videos que fueron creados digitalmente, sin el uso de grandes recursos ni el consentimiento de las personas reales involucradas, y que nos hacen creer que alguien dijo algo que nunca dijo. Ya son utilizados para estafar y para ejercer manipulación masiva con fines políticos. De manera que la investigación del equipo de Sung Park involucra ciertos riesgos: cualquier tecnología de generación de agentes plantea dudas sobre la facilidad con la que las personas pueden crear herramientas para hacerse pasar por otros en línea, diciendo o autorizando cosas que no tenían intención de decir.

Además, otros trabajos, liderados por Dongwook Yoon, de la Universidad de Columbia Británica (en Canadá), plantearon posibles riesgos de los “sujetos” artificiales, como el creciente miedo a las máquinas y la dificultad de crear vínculos, debido a la presencia generalizada de clones informatizados. Los métodos de evaluación que utilizó el equipo para probar qué tan bien los agentes de IA replicaban a sus seres humanos correspondientes también fueron bastante básicos.

Estos incluyeron la Encuesta Social General, que recopila información sobre la demografía, la felicidad, los comportamientos y más, y evaluaciones de los cinco grandes rasgos de personalidad: apertura a la experiencia, escrupulosidad, extroversión, amabilidad y neuroticismo. Estas pruebas se utilizan comúnmente en la investigación de las ciencias sociales, pero no pretenden capturar todos los detalles únicos que hacen que una persona sea quien es, con toda su singularidad y complejidad. Los agentes de IA también fueron peores a la hora de replicar a los seres humanos en pruebas de comportamiento como el “juego del dictador”, que pretende mostrar cómo los participantes consideran valores como la justicia.

“Es posible minimizar esos riesgos mediante medidas rigurosas, garantizando que los individuos sean plenamente conscientes de cómo se utilizan sus clones”, afirma Park, tal vez demasiado optimista. Gemelos digitales, hacia allí miran algunos modelos de inteligencia artificial que son diseñados para replicar personalidades individuales.

Comentarios